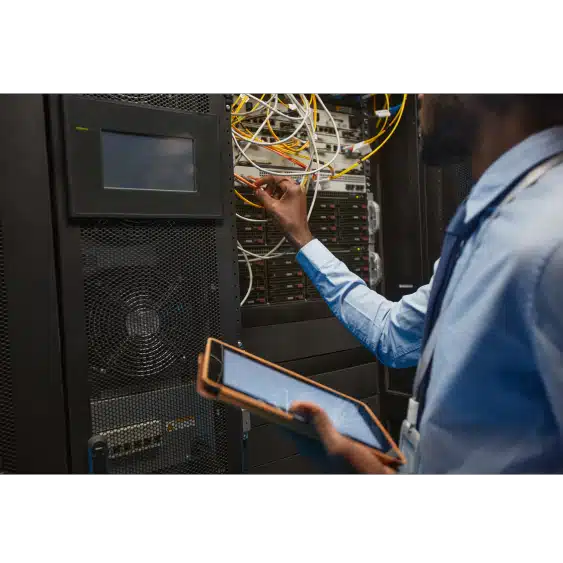

La virtualisation serveur s’impose aujourd’hui comme une solution incontournable dans les environnements informatiques modernes. Elle consiste à créer plusieurs machines virtuelles sur un seul serveur physique, grâce à un hyperviseur capable d’exécuter plusieurs systèmes d’exploitation indépendamment les uns des autres. Cette approche permet de mutualiser les ressources matérielles, d’optimiser la gestion des capacités et de réduire considérablement le coût d’infrastructure.

Dans un contexte où les entreprises recherchent performance, flexibilité et réduction des charges, cette technologie offre un véritable levier d’optimisation. Chaque machine virtuelle fonctionne comme un environnement isolé, avec son propre système, ses applications, ses données et son réseau, tout en partageant le même matériel hôte. Cette architecture facilite la maintenance, le déploiement, la migration, tout en assurant une meilleure continuité de service.

Grâce à la virtualisation, il devient possible de faire fonctionner différents types de logiciels, d’outils ou de services cloud sans dépendre d’un matériel spécifique. Cela améliore l’utilisation des ressources, réduit l’espace requis, limite les problèmes de compatibilité et simplifie le travail quotidien des équipes. L’environnement virtuel, bien conçu, peut s’adapter à chaque besoin, en fonction du niveau de charge, du type d’application, ou encore du stockage nécessaire.

Du serveur au réseau, du logiciel au processeur, chaque élément joue un rôle dans le bon fonctionnement de cette infrastructure virtualisée. En choisissant la bonne solution, il est possible de créer un système à la fois stable, efficace et évolutif, capable de répondre aux exigences des SI les plus complexes.

Qu’est-ce que la virtualisation des serveurs ?

La virtualisation des serveurs permet de créer plusieurs serveurs virtuels sur un seul serveur physique, chacun fonctionnant de manière indépendante. Traditionnellement, chaque serveur est dédié à une tâche ou application spécifique avec un système d’exploitation et des ressources bien définies, ce qui nécessite beaucoup de matériel, d’espace et d’énergie, et laisse souvent les ressources sous-utilisées.

La virtualisation résout ces problèmes en permettant de partager les ressources matérielles d’un serveur unique entre plusieurs environnements virtuels, appelés machines virtuelles (VM). Au lieu d’ajouter plus de serveurs physiques, la virtualisation optimise les ressources existantes en hébergeant plusieurs VM sur un même serveur. Chaque machine virtuelle dispose de son propre système d’exploitation et fonctionne indépendamment des autres, assurant une isolation efficace.

L’hyperviseur, le logiciel de virtualisation, gère la répartition des ressources (CPU, mémoire, stockage) entre les VM tout en les isolant. Cela permet à chaque serveur virtuel de fonctionner sans interférer avec les autres, garantissant une utilisation optimale des ressources et limitant les temps d’arrêt.

Grâce à la virtualisation informatique, les serveurs sont consolidés, ce qui réduit la consommation d’énergie et les coûts tout en améliorant l’efficacité et la flexibilité de l’infrastructure IT, notamment dans les datacenters et environnements cloud. Cette solution permet à plusieurs systèmes d’exploitation de coexister et d’exécuter des applications en parallèle, maximisant les capacités de traitement.

Comment fonctionne la virtualisation serveur ?

Le fonctionnement de la virtualisation des serveurs repose sur la capacité à partitionner les ressources physiques d’un serveur pour y exécuter plusieurs machines virtuelles (VM) de manière simultanée. Le processus débute par la sélection d’un serveur dédié, conçu pour utiliser les ressources de manière optimale. La première étape consiste à évaluer la capacité disponible en termes de mémoire, de processeurs et de stockage afin de déterminer combien de machines virtuelles peuvent être créées et quelle puissance de calcul elles peuvent fournir.

La clé de la virtualisation est l’utilisation d’un hyperviseur, un logiciel qui permet de diviser les ressources matérielles du serveur en plusieurs environnements virtuels indépendants. Il existe deux types d’hyperviseurs :

Hyperviseur de type 1, ou « bare metal », qui s’installe directement sur le matériel du serveur. Ce type est souvent utilisé pour les environnements de production, car il offre une performance élevée en accédant directement aux ressources physiques.

Hyperviseur de type 2, qui s’installe au niveau du système d’exploitation hôte. Ce type est généralement utilisé dans des environnements de test ou de développement, car il est plus flexible mais moins performant que le type 1.

Une fois l’hyperviseur en place, il partitionne le serveur physique pour permettre l’exécution simultanée de plusieurs machines virtuelles, chacune avec son propre système d’exploitation et ses applications. Chaque VM est isolée des autres, ce qui garantit qu’un incident sur une VM n’impacte pas les autres.

La virtualisation permet ainsi de créer des environnements virtuels non seulement pour les serveurs, mais aussi pour les applications, le stockage et les réseaux, maximisant l’utilisation des ressources disponibles et offrant une grande flexibilité dans la gestion des charges de travail.

Quels sont les types de virtualisation des serveurs ?

La virtualisation des serveurs est un pilier des infrastructures modernes, permettant d’optimiser l’utilisation des ressources et de faciliter la gestion des environnements informatiques. Plusieurs types de virtualisation répondent à des besoins spécifiques selon les objectifs des entreprises. Voici les principaux types de virtualisation des serveurs :

Virtualisation complète (Full Virtualization)

La virtualisation complète repose sur un hyperviseur qui crée un environnement totalement indépendant du matériel sous-jacent. Chaque machine virtuelle (VM) possède son propre système d’exploitation et fonctionne comme si elle disposait de son propre matériel physique. L’hyperviseur gère l’isolation entre les machines et la distribution des ressources matérielles (CPU, RAM, stockage). Ce type permet d’exécuter plusieurs systèmes d’exploitation sur un même serveur sans qu’ils interfèrent entre eux, idéal pour des environnements nécessitant un isolement strict.

Paravirtualisation

Dans la paravirtualisation, l’hyperviseur ne simule pas totalement le matériel. Les systèmes d’exploitation des VM sont conscients qu’ils sont virtualisés, ce qui améliore la communication entre les VM et l’hyperviseur. Cette réduction de la surcharge de virtualisation améliore les performances globales. Cependant, ce type de virtualisation nécessite des systèmes d’exploitation modifiés, adaptés à cet environnement. Il est couramment utilisé lorsque la performance est une priorité absolue, notamment dans les environnements exigeants.

Virtualisation au niveau du système d'exploitation (OS-Level Virtualization)

Également appelée conteneurisation, cette approche se distingue par l’absence d’hyperviseur. Un seul système d’exploitation est partagé entre plusieurs conteneurs isolés, chacun ayant sa propre copie virtuelle du système d’exploitation. Cela consomme moins de ressources, car il n’y a pas de surcouche d’hyperviseur. Cette méthode est particulièrement adaptée aux environnements homogènes, où toutes les instances utilisent le même système d’exploitation, comme c’est le cas avec des solutions comme Docker. Elle est appréciée pour sa légèreté et sa rapidité.

Virtualisation matérielle assistée

La virtualisation matérielle assistée utilise des fonctionnalités spécifiques des processeurs modernes, comme Intel VT ou AMD-V, pour améliorer les performances des machines virtuelles. Ces extensions matérielles permettent de soulager l’hyperviseur en accélérant le traitement des instructions virtualisées. Ce type de virtualisation est particulièrement avantageux dans les environnements nécessitant une forte capacité de calcul, car il améliore l’efficacité tout en réduisant la charge de traitement du serveur.

Quelle est la différence entre virtualisation et cloud computing ?

La virtualisation et le cloud computing sont des concepts fondamentaux en informatique, mais ils répondent à des besoins distincts tout en étant étroitement liés. La virtualisation est une technologie qui permet de créer plusieurs environnements virtuels sur une seule machine physique en utilisant un hyperviseur. Chaque environnement virtuel fonctionne indépendamment avec son propre système d’exploitation, ses applications, et ses données. Cette approche permet aux entreprises de maximiser l’utilisation de leurs ressources matérielles, de réduire les coûts, et d’améliorer la gestion de leur infrastructure IT.

Le cloud computing, en revanche, repose sur la virtualisation pour fournir des services informatiques à distance via un réseau, généralement Internet. Il offre des solutions flexibles, évolutives et accessibles en fonction des besoins de l’entreprise. Les services cloud incluent des machines virtuelles, du stockage, des logiciels, et des applications en mode SaaS, PaaS ou IaaS.

Avantages de la virtualisation des serveurs

La virtualisation est une technologie qui transforme la manière dont les organisations gèrent leurs infrastructures IT. En optimisant l’utilisation des ressources et en améliorant la flexibilité, elle permet de surmonter les limites des configurations traditionnelles basées sur des équipements dédiés. Voici les principaux avantages de cette approche :

Utilisation optimale des ressources

Dans une configuration classique, les équipements sont souvent sous-utilisés. Chaque unité est dédiée à une tâche ou une application spécifique, ce qui signifie que les ressources matérielles (processeur, mémoire, stockage) ne sont pas pleinement exploitées. Avec la virtualisation, un seul dispositif peut héberger plusieurs environnements virtuels, chacun ayant son propre système d’exploitation et ses applications. Cela permet de partager efficacement les ressources et d’éviter le gaspillage en répartissant dynamiquement les charges de travail. La virtualisation maximise donc l’utilisation des capacités disponibles, permettant de faire plus avec moins de matériel.

Réduction des dépenses liées à l'infrastructure

Un avantage clé de la virtualisation est la réduction des dépenses liées à l’infrastructure. En consolidant plusieurs environnements virtuels sur une seule machine, les organisations réduisent leurs besoins en matériel, en évitant de multiplier les achats. De plus, cela diminue les frais liés à l’espace de stockage dans les datacenters, à la consommation d’énergie et au refroidissement, puisque moins d’équipements sont nécessaires pour gérer la même charge de travail.

Flexibilité et évolutivité

La virtualisation des serveurs offre une grande flexibilité dans la gestion des environnements IT. Il est facile de créer, modifier ou supprimer des environnements virtuels selon les besoins de l’organisation, sans ajouter de nouveaux équipements. Cela permet de s’adapter rapidement aux fluctuations de la charge de travail, aux pics d’activité ou aux nouvelles opportunités d’affaires. De plus, la scalabilité de cette technologie permet de déployer rapidement de nouveaux environnements virtuels pour gérer la croissance des besoins informatiques sans nécessiter d’importants investissements

Simplification de la gestion et de la maintenance

La virtualisation permet de simplifier la gestion des infrastructures informatiques. Avec un nombre réduit d’équipements à maintenir, les tâches de gestion sont centralisées et plus faciles à administrer. Les hyperviseurs facilitent la gestion des environnements virtuels, permettant une allocation dynamique des ressources en fonction des besoins spécifiques. Cela simplifie la maintenance et la surveillance, augmentant ainsi l’efficacité des équipes IT.

Amélioration de la continuité des services

Grâce à la virtualisation, il est possible de migrer des environnements virtuels d’un appareil à un autre sans interruption, grâce à un processus appelé migration à chaud. Cela améliore la disponibilité des services et minimise les interruptions, car la maintenance, les mises à jour et les pannes peuvent être gérées sans affecter les opérations. Les fonctionnalités de sauvegarde et de récupération intégrées offrent également une meilleure protection des données et une reprise rapide après un incident, renforçant ainsi la continuité des activités.

Renforcement de la sécurité

La virtualisation permet de sécuriser les environnements IT en isolant les machines virtuelles les unes des autres. Un problème ou une attaque sur un environnement virtuel n’affecte pas les autres, améliorant ainsi la résilience globale. De plus, la gestion centralisée permet d’appliquer des politiques de sécurité plus strictes de manière uniforme à travers l’infrastructure virtuelle.

Y a t-il des inconvénients pour les entreprises à la virtualisation des serveurs ?

1. Complexité de gestion et de mise en œuvre

La virtualisation peut être complexe à mettre en place et à gérer, surtout pour les entreprises qui n’ont pas une expertise IT avancée. L’installation et la configuration des hyperviseurs, la gestion des machines virtuelles, ainsi que l’optimisation des ressources demandent des compétences techniques spécifiques. Si ces compétences ne sont pas disponibles en interne, il peut être nécessaire de faire appel à des experts externes, augmentant ainsi les coûts.

2. Coût initial d’investissement

Bien que la virtualisation réduise les coûts à long terme, elle peut impliquer des investissements initiaux élevés. Les entreprises doivent souvent acheter des serveurs puissants et des licences pour les hyperviseurs (comme VMware ou Microsoft Hyper-V), ainsi que des outils de gestion spécifiques. Ce coût peut être prohibitif pour les petites et moyennes entreprises qui disposent de budgets IT plus restreints.

3. Dépendance à une infrastructure centralisée

En virtualisant les serveurs, les entreprises deviennent plus dépendantes de leur infrastructure centralisée. Si le serveur physique qui héberge plusieurs machines virtuelles tombe en panne, cela peut affecter toutes les VM hébergées sur ce serveur, ce qui entraîne des interruptions de service importantes. Bien que des solutions de redondance et de sauvegarde puissent atténuer ce risque, elles ajoutent des coûts supplémentaires.

4. Problèmes de sécurité

La virtualisation peut également introduire des problèmes de sécurité. Si une machine virtuelle est compromise, cela peut affecter l’ensemble de l’infrastructure virtuelle. Une gestion rigoureuse de la sécurité est donc essentielle pour éviter toute vulnérabilité dans l’environnement virtualisé.

Comment Assurer La Sécurité En Virtualisation

La sécurité en virtualisation repose sur une série de bonnes pratiques essentielles pour garantir un environnement sécurisé et fiable. Avec la multiplication des machines virtuelles sur un même serveur physique, le moindre incident ou la moindre faille peut impacter plusieurs systèmes à la fois. Il devient donc indispensable de mettre en place une stratégie robuste.

Renforcer l’isolation des machines virtuelles

L’isolation des machines virtuelles est la première barrière de sécurité. Chaque instance doit rester indépendante, même si elle partage les mêmes ressources matérielles. Cela passe par un paramétrage strict de l’hyperviseur, la limitation des connexions inter-VM, et l’usage de pare-feux virtuels dédiés. Une machine compromise ne doit jamais pouvoir en affecter une autre.

Identifier et anticiper les risques de virtualisation

Les risques de virtualisation sont spécifiques : erreurs de configuration, failles de l’hyperviseur, attaques latérales entre VM, etc. Pour les limiter, il faut effectuer des audits réguliers, surveiller les accès, et tenir à jour tous les logiciels du socle technique (système, hyperviseur, outils de gestion).

Assurer la protection des données sensibles

La protection des données dans un environnement virtualisé nécessite une approche globale : chiffrement, segmentation des accès, sauvegardes régulières, journalisation des actions. Il est également conseillé de cloisonner les environnements selon leur niveau de sensibilité (production, test, etc.) pour limiter les fuites potentielles.

Maintenir un environnement sécurisé sur le long terme

Un environnement sécurisé ne repose pas uniquement sur la technique. Il s’agit aussi de processus : gestion des droits d’accès, contrôle des utilisateurs, détection des anomalies, et automatisation des tâches critiques. Un bon plan de sécurité inclut la réactivité face aux incidents et la capacité à restaurer rapidement les services en cas de problème.